SÍNTESIS DE LA SESIÓN DEL 18 DE JUNIO DE 2020

| Descargar en formato PDF | ||

| Fotografías disponibles (Flickr) | ||

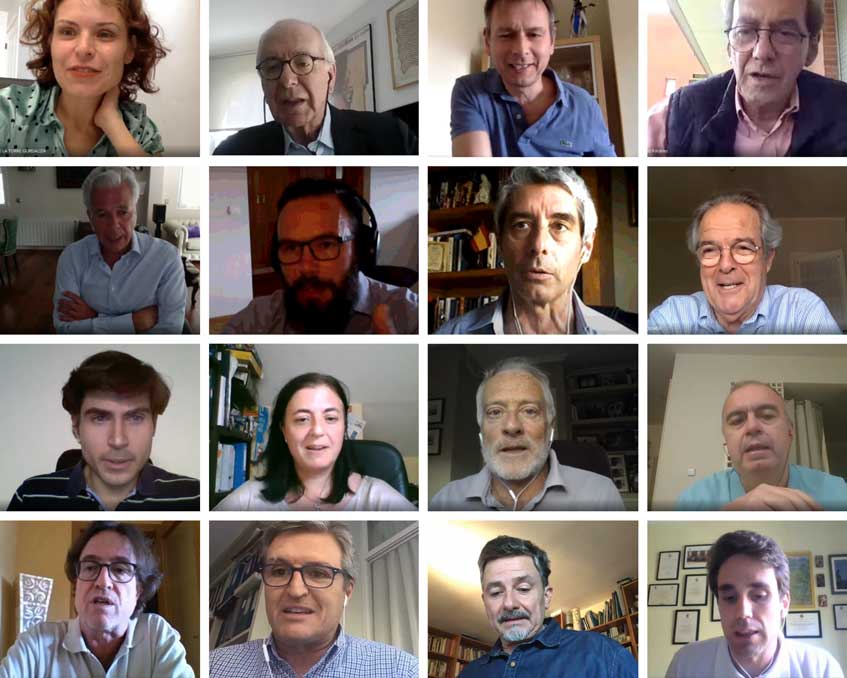

El 18 de junio de 2020, el comité de expertos del Seminario Permanente La Huella Digital: ¿servidumbre o servicio? ha celebrado su quinta sesión por videoconferencia. La reunión se ha centrado en el tema del uso de datos en las previsiones meteorológicas y la climatología, con un comentario sobre datos y algoritmos en las operaciones militares.

Daniel Santos Muñoz, líder del proyecto AEMET-HIRLAM, ha presentado la sesión, seguido por los comentarios de Ángel Gómez de Ágreda, Coronel Jefe en el Área de Análisis Geopolítico de DICOES/SEGENPOL. De la amplia información técnica presentada se deducen varios temas transversales de debate: el primero se relaciona con la capacidad de previsión meteorológica y medición del cambio climático ante posibles límites en la capacidad de cómputo para procesar la ingente cantidad de datos climatológicos que se crean en la actualidad. También se abordó la interrelación entre instituciones públicas e intereses privados, y la competencia entre estos últimos en la explotación de los datos meteorológicos y climáticos. Un tercer tema tiene que ver con la comunicación de la información climatológica, la confianza en las mediciones y la necesidad de educación ambiental.

El impacto de la información climatológica

La importancia de la climatología puede pasar desapercibida hasta que ocurren sucesos en los que su relevancia se eleva de forma exponencial. Un ejemplo de ello es el impacto que tuvo la ola de calor de 2003 en Europa. Durante el verano del 2003 la OMS registró 35 000 muertes relacionadas con el calor en el continente europeo, la tasa de mortalidad en Francia aumentó en un 54%. A lo anterior se suman las pérdidas económicas de miles de millones de euros debido al fracaso de la cosecha. Sólo en Portugal los daños de los incendios forestales tuvieron un costo de 1,6 mil millones.

El impacto del clima en la sociedad hace que la predicción meteorológica haya ido ganando cada vez más espacio en los medios de comunicación. Este tipo de predicción se hace con métodos numéricos, en grandes programas en los que se intenta incluir el máximo número de componentes del sistema climático. En 1860 se realizó la primera predicción meteorológica con bases científicas gracias a la invención del telégrafo que sirvió para la transmisión de observaciones. Esta predicción se le atribuye a Robert Fitzroy, almirante británico que comandó el HMS Beagle, navío que llevó a Charles Darwin alrededor del mundo. Pero fue en 1904 cuando el físico noruego Vilhelm Bjerknes sentó las bases que hoy permiten expresar la evolución del tiempo partiendo de una situación meteorológica inicial mediante el uso de leyes físicas.

Bjerknes propuso las llamadas ecuaciones primitivas, que solo pueden resolverse de forma aproximada y requieren el manejo de grandes volúmenes de datos y millones de operaciones matemáticas que necesitan para su solución una capacidad de cálculo que solo tienen los computadores. Fue en 1950, con la llegada del primer supercomputador (ENIAC) cuando se realizó el primer pronóstico del tiempo con un modelo fisicomatemático de la atmósfera. Además de una ingente capacidad de cálculo, para la predicción climatológica se necesita previamente una gran capacidad de obtención de observaciones del estado del clima. Los datos de registros del sistema climático se difunden globalmente en tiempo real gracias a los observatorios meteorológicos, a las estaciones automáticas, globos sonda, radares, satélites, boyas, barcos, aviones, entre otros. A los proveedores oficiales de información climática se ha añadido la información voluntariamente proporcionada por ciudadanos, así como los datos típicos de la huella digital proporcionados por redes sociales o por la telefonía móvil. En los últimos años, muchos actores del sector privado han descubierto el interés que puede tener para su desarrollo el conocimiento más exacto de previsiones meteorológicas estacionales, desde la moda hasta la industria alimentaria. Ello ha motivado inversiones privadas de varios grandes grupos tecnológicos en el desarrollo de nuevos modelos predictivos, competidores de los que manejan los estados y las entidades públicas.

Daniel Santos Muñoz, líder del proyecto AEMET-HIRLAM

Pero tanto en los datos como en el cálculo, hay limitaciones que condicionan la fiabilidad de los pronósticos: por un lado, la naturaleza caótica del sistema climático y, por otro, los límites de la capacidad de cálculo de los superordenadores. El hecho de que pequeñas desviaciones, como la que provoca el vuelo de una mariposa, puedan llegar a provocar un tornado (el conocido efecto propuesto por Edward Norton Lorenz), supone un gran problema para la predicción climatológica. A esto se añade la frontera de la capacidad de miniaturización de los procesadores que determinan la capacidad de cálculo de los superordenadores al dejar de cumplirse la conocida Ley de Moore (duplicación cada dos años del número de transistores en un circuito integrado). Hoy se cree que ese ritmo de integración no es sostenible, pero han aparecido nuevas tecnologías tales como el machine learning y la Inteligencia Artificial y se prevé para un futuro relativamente cercano la revolución de la computación cuántica, que pueden suponer nuevos avances inéditos.

Frente a la carrera aparentemente ilimitada hacia mayores cantidades de datos y mayor capacidad de cálculo, se comenta, desde el punto de vista del uso de datos en las fuerzas armadas, la idea de que los sistemas deben centrarse no tanto en la perfección tecnológica sino en la utilidad práctica para resolver problemas. En esta línea, se cree que hay una necesidad de determinar un umbral mínimo de información necesaria para la toma de decisiones. Sobre todo, en el caso en el que una decisión rápida sea mejor que una acción perfecta, siempre y cuando se consiga llegar al objetivo. Es decir que, los sistemas deberían centrarse en la eficiencia y dejar de lado la perfección. Un ejemplo de esto se da en el ámbito militar en donde lo que se pretende es determinar escenarios posibles, y no previsiones exactas, y se pone el énfasis en una actualización continua para adecuar la estrategia y el comportamiento en función de nuevos datos obtenidos desde el frente.

El umbral de información necesaria es primordial para evitar el riesgo de “parálisis por el análisis” en ámbitos en los que la observación constante y el cúmulo de datos pueden hacer que no se tome ninguna decisión: el uso de los sistemas de big data y los algoritmos pueden resultar contraproducentes si suponen un incremento en el número de elementos que se tienen en cuenta, sin que aumente significativamente la precisión de la información global.

Ángel Gómez de Ágreda, Coronel Jefe en el Área de Análisis Geopolítico de DICOES/SEGENPOL

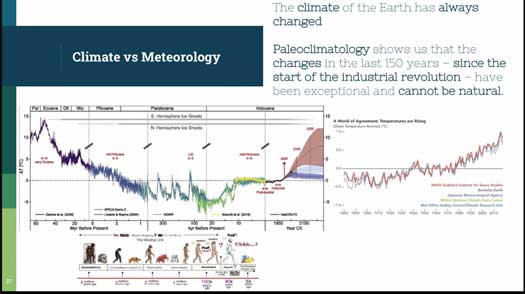

En otros ámbitos en los que ha trabajado el seminario, se ha observado que la explotación de datos mediante algoritmos tiende a aumentar el conocimiento de los patrones de comportamiento y, en última instancia, a influenciar o incluso a manipular dichos patrones. En la experiencia del ámbito militar se puede hablar sin duda de la extensión del uso de datos hacia la manipulación o incluso la falsificación, dentro de un contexto esencialmente conflictivo. También se puede observar, sin embargo, que la abundancia de datos permite la aplicación de distintas metodologías de combate – la “guerra híbrida” que mezcla armas con otras formas de confrontación – y un mejor control del riesgo bélico propiamente dicho. En el campo de la meteorología, los intentos de manipulación de la realidad están prometidos al fracaso dadas las enormes cantidades de energía que supone cualquier efecto en los fenómenos climatológicos. Y en cuanto a la acción contra el cambio climático, la realidad demuestra que los cambios necesarios para limitar el calentamiento global (descarbonización de la economía) son extraordinariamente pesados y lentos en sus efectos.

La ciencia ha consensuado la realidad de cambios en el clima que se deben a la actividad humana, así como las consecuencias que esto puede producir en la vida del hombre en la tierra. No es el planeta el que está amenazado por el cambio climático, son la vida y el hábitat humano los que no están preparados para soportarlo. Pero resulta claro que hay un problema de percepción del riesgo, ya que, a pesar de los datos y la información científica, se sigue sembrando la duda al respecto. El negacionismo respecto al riesgo climatológico se alimenta desde algunos líderes gubernamentales y desde algunos intereses privados. Sin embargo, existen otras instancias públicas y otros grandes grupos empresariales que, al contrario, están actuando para avanzar con decisión hacia los cambios necesarios.

Una de las dificultades que ralentizan el proceso de cambio reside en la falta de capacidad de medición del impacto ambiental de las propias acciones, ya sea a nivel individual, ya sea a nivel de empresa o de país. Es necesario un gran esfuerzo cooperativo global – que desgraciadamente en estos momentos encuentra obstáculos crecientes en las derivas proteccionistas y nacionalistas – para aumentar la capacidad de medir de forma fehaciente y creíble el coste económico de la no-acción contra el cambio climático. Todo será más claro cuando estos costes aparezcan de forma pública y contrastada: cuando la contabilidad nacional y empresarial refleje las consecuencias de los cambios climatológicos y los riesgos que entrañan, quizá podrían surgir nuevas sinergias entre los sectores público y privado que beneficiarían al conjunto social.

Comunicación, confianza y educación ambiental

El problema del cambio climático se acentúa con la imposibilidad de comunicar el gran volumen de información a los individuos, a las empresas y a los gobernantes. Hay un problema de comunicación difícil de abordar ya que en él se mezcla un problema de confianza que surge por quien siembra la duda para su conveniencia (es decir, los cambios necesarios para parar el cambio climático afectarían negativamente a la economía en muchos aspectos) y el problema que se deriva de la escasa educación ambiental en general.

La concienciación de la población respecto al cambio climático surgirá con la llegada de la educación ambiental en el sistema educativo y con el aumento en la confianza en los datos meteorológicos, para lo que es necesario un modelo de gobernanza adecuado. En línea con la educación, lo importante es que cada individuo sea consciente de qué significa la huella que deja en el planeta y cómo ésta puede impactar de forma negativa y positiva. Esta educación debe extenderse a escuelas, universidades y empresas. Este sistema educativo, que será efectivo si se promueve desde los gobiernos y de forma global, debe basarse en trabajar la racionalidad práctica, en la que la decisión no la da la cantidad de datos, sino la adecuación con el fin buscado, una tarea que solo el hombre (y no la máquina) es capaz de hacer. Es decir que, lo propio de la capacidad humana no es la obtención de información, sino la toma de decisiones.

Listado de asistentes

- Alfredo Marcos Martínez, Catedrático de Filosofía de la Ciencia, Universidad de Valladolid

- Alfredo Pastor Bodmer, Economista, Profesor emérito, IESE

- Almudena Rodríguez Beloso, Directora de Relaciones Institucionales y Corporativas, VALORA

- Ángel Gómez de Agreda, Coronel Jefe, Área de Análisis Geopolítico DICOES/ SEGENPOL

- Ángel González Ferrer, Director Ejecutivo Centro Cultura Digital Consejo Pontificio para la cultura del Vaticano

- Carolina Villegas, Investigadora de la Cátedra Iberdrola de Ética Financiera y Empresarial, Universidad Pontificia de Comillas

- Daniel Santos, Project Leader AEMET - HIRLAM

- David Roch Dupré, Investigador en Formación, Instituto de Investigación Tecnológica

- Diego Bodas, Lead Data Scientist en MAPFRE

- Domingo Sugranyes, Director del Seminario de Huella Digital

- Esther de la Torre, Responsible Digital Banking Manager, BBVA

- Francisco Javier López Martín, Ex-Secretario General, CCOO de Madrid

- Guillermo Monroy Pérez, Profesor, Instituto de Estudios Bursátiles

- Idoia Salazar, Experta en Ética en IA, Universidad CEU San Pablo

- Idoya Zorroza, Profesora Contratada Doctora, Facultad de Filosofía, Universidad Pontificia de Salamanca

- Ignacio Quintanilla Navarro, Filósofo, Educador, Universidad Complutense de Madrid

- Javier Prades, Rector, Universidad Eclesiástica San Dámaso

- Jesús Avezuela, Director General de la Fundación Pablo VI

- Jesús Sánchez Camacho, Profesor de la Facultad de Teología, Universidad Pontificia Comillas

- José Luis Calvo, Director de Inteligencia Artificial en SNGULAR

- José Luis Fernández, Director de la Cátedra Iberdrola de Ética Económica y Empresarial, ICADE

- José Manuel González-Páramo, Asesor Externo del BBVA

- José Ramón Amor, Coordinador del Observatorio de Bioética de la Fundación Pablo VI

- Juan Benavides, Catedrático de comunicación, Universidad Complutense de Madrid

- Pablo García Mexía, Jurista Digital, Of Council Ashurst LLP

- Raúl González Fabre, Profesor, Universidad Pontificia de Comillas

- Richard Benjamins, Embajador de Data & IA, Telefónica

- Samuel Privara, Experto en el área de cibernética, robótica e inteligencia artificial